Para satisfacer las necesidades de los servicios en la nube, la red se divide gradualmente en red subyacente y red superpuesta. La red subyacente comprende los equipos físicos, como el enrutamiento y la conmutación, en los centros de datos tradicionales, que aún se basan en el concepto de estabilidad y proporcionan capacidades confiables de transmisión de datos. La red superpuesta es la red empresarial encapsulada en ella, más cerca del servicio, mediante la encapsulación de los protocolos VXLAN o GRE, para brindar a los usuarios servicios de red fáciles de usar. La red subyacente y la red superpuesta están relacionadas y desacopladas, y se interrelacionan entre sí, pudiendo evolucionar de forma independiente.

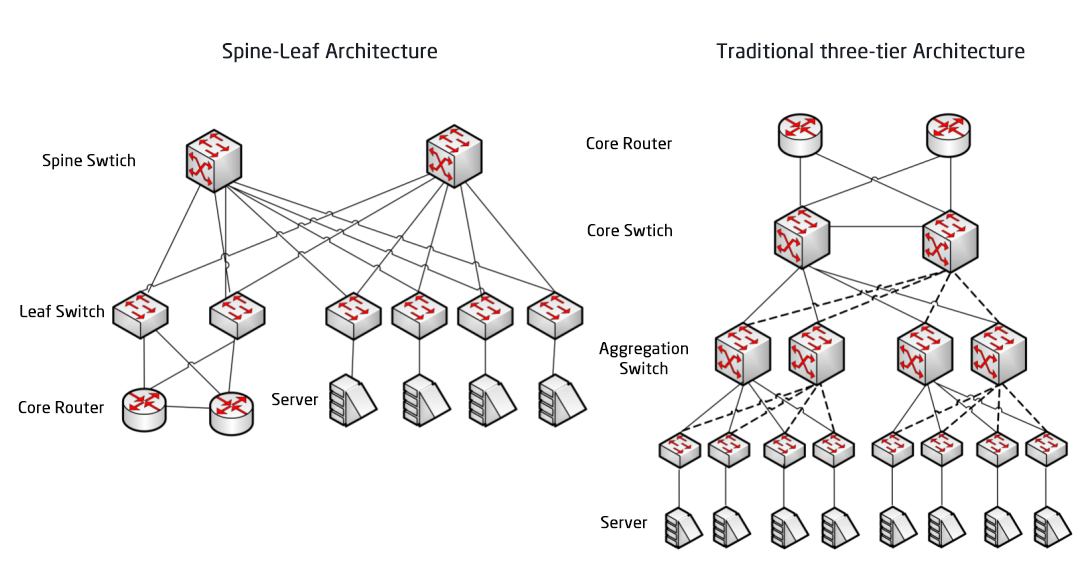

La red subyacente es la base de la red. Si esta es inestable, no existe un SLA para la empresa. Tras la arquitectura de red de tres capas y la arquitectura de red Fat-Tree, la arquitectura de red del centro de datos está en transición hacia la arquitectura Spine-Leaf, que marcó el comienzo de la tercera aplicación del modelo de red CLOS.

Arquitectura de red de centro de datos tradicional

Diseño de tres capas

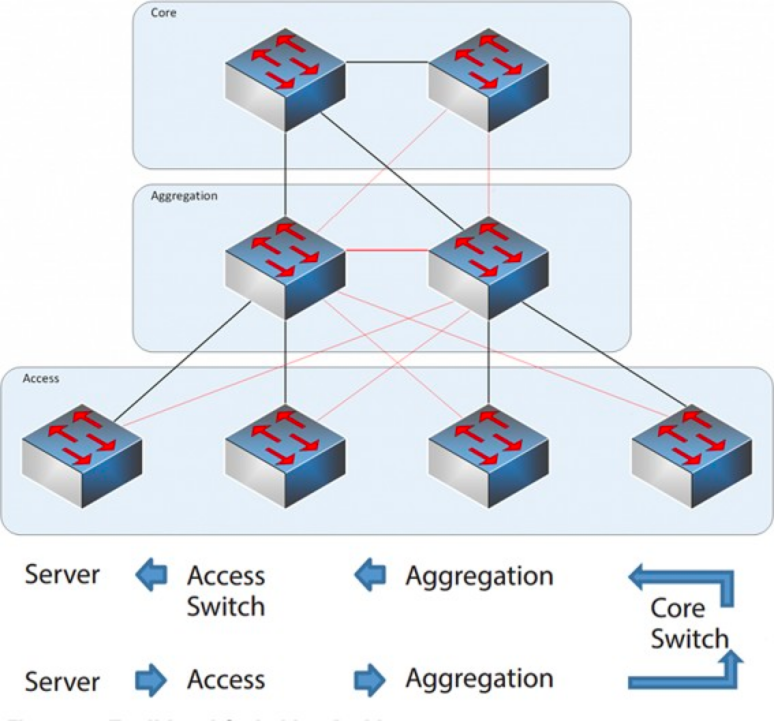

De 2004 a 2007, la arquitectura de red de tres niveles fue muy popular en los centros de datos. Consta de tres capas: la capa central (la columna vertebral de conmutación de alta velocidad de la red), la capa de agregación (que proporciona conectividad basada en políticas) y la capa de acceso (que conecta las estaciones de trabajo a la red). El modelo es el siguiente:

Arquitectura de red de tres capas

Capa central: los conmutadores centrales proporcionan reenvío de paquetes de alta velocidad dentro y fuera del centro de datos, conectividad a múltiples capas de agregación y una red de enrutamiento L3 resistente que normalmente sirve a toda la red.

Capa de agregación: el conmutador de agregación se conecta al conmutador de acceso y proporciona otros servicios, como firewall, descarga de SSL, detección de intrusiones, análisis de red, etc.

Capa de acceso: Los conmutadores de acceso suelen estar en la parte superior del rack, por lo que también se denominan conmutadores ToR (Top of Rack), y se conectan físicamente a los servidores.

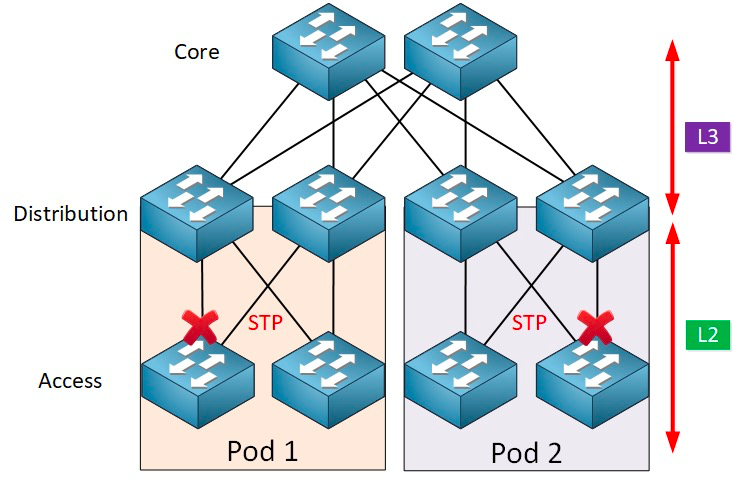

Normalmente, el conmutador de agregación es el punto de demarcación entre las redes L2 y L3: la red L2 se encuentra por debajo del conmutador de agregación y la red L3 por encima. Cada grupo de conmutadores de agregación gestiona un punto de entrega (POD), y cada POD es una red VLAN independiente.

Protocolo de bucle de red y árbol de expansión

La formación de bucles se debe principalmente a la confusión causada por rutas de destino poco claras. Al construir redes, los usuarios suelen utilizar dispositivos y enlaces redundantes para garantizar la fiabilidad, por lo que inevitablemente se forman bucles. La red de capa 2 se encuentra en el mismo dominio de difusión, y los paquetes de difusión se transmiten repetidamente en el bucle, formando una tormenta de difusión que puede causar el bloqueo de puertos y la paralización instantánea de equipos. Por lo tanto, para prevenir las tormentas de difusión, es necesario prevenir la formación de bucles.

Para evitar la formación de bucles y garantizar la fiabilidad, solo es posible convertir dispositivos y enlaces redundantes en dispositivos y enlaces de respaldo. Es decir, los puertos y enlaces de los dispositivos redundantes se bloquean en circunstancias normales y no participan en el reenvío de paquetes de datos. Solo cuando falla el dispositivo, puerto o enlace de reenvío actual, lo que provoca congestión en la red, se abren los puertos y enlaces redundantes para que la red pueda restablecerse a la normalidad. Este control automático se implementa mediante el Protocolo de Árbol de Expansión (STP).

El protocolo de árbol de expansión opera entre la capa de acceso y la capa receptora, y se basa en un algoritmo de árbol de expansión que se ejecuta en cada puente habilitado para STP. Este algoritmo está diseñado específicamente para evitar bucles de puenteo en presencia de rutas redundantes. STP selecciona la mejor ruta de datos para el reenvío de mensajes y rechaza los enlaces que no forman parte del árbol de expansión, dejando solo una ruta activa entre dos nodos de red cualesquiera; el otro enlace ascendente se bloquea.

STP ofrece muchas ventajas: es sencillo, listo para usar y requiere muy poca configuración. Las máquinas de cada pod pertenecen a la misma VLAN, por lo que el servidor puede migrar la ubicación arbitrariamente dentro del pod sin modificar la dirección IP ni la puerta de enlace.

Sin embargo, STP no puede utilizar rutas de reenvío paralelas, ya que siempre deshabilitará las rutas redundantes dentro de la VLAN. Desventajas de STP:

1. Convergencia topológica lenta. Cuando la topología de la red cambia, el protocolo de árbol de expansión tarda entre 50 y 52 segundos en completar la convergencia topológica.

2. No se puede proporcionar la función de equilibrio de carga. Cuando se produce un bucle en la red, el protocolo de árbol de expansión simplemente bloquea el bucle, impidiendo que el enlace reenvíe paquetes de datos, desperdiciando recursos de la red.

Virtualización y desafíos del tráfico este-oeste

Después de 2010, para optimizar el uso de los recursos informáticos y de almacenamiento, los centros de datos comenzaron a adoptar la tecnología de virtualización, lo que generó una gran cantidad de máquinas virtuales en la red. La tecnología virtual transforma un servidor en múltiples servidores lógicos: cada máquina virtual puede ejecutarse de forma independiente, tiene su propio sistema operativo, aplicación, dirección MAC e IP, y se conecta a la entidad externa a través del conmutador virtual (vSwitch) dentro del servidor.

La virtualización conlleva un requisito adicional: la migración en vivo de máquinas virtuales, que permite migrar un sistema de máquinas virtuales de un servidor físico a otro manteniendo el funcionamiento normal de los servicios en ellas. Este proceso no afecta a los usuarios finales; los administradores pueden asignar recursos del servidor con flexibilidad, o reparar y actualizar servidores físicos sin afectar el uso normal de los usuarios.

Para garantizar que el servicio no se interrumpa durante la migración, es necesario que no solo se mantenga la dirección IP de la máquina virtual, sino también su estado de ejecución (como el estado de la sesión TCP). Por lo tanto, la migración dinámica de la máquina virtual solo puede realizarse en el mismo dominio de capa 2, pero no a través de la migración del dominio de capa 2. Esto crea la necesidad de dominios L2 más grandes desde la capa de acceso hasta la capa central.

La división entre L2 y L3 en la arquitectura tradicional de red de capa 2 grande se encuentra en el conmutador central, y el centro de datos bajo este conmutador constituye un dominio de difusión completo, es decir, la red L2. De esta forma, se puede implementar la arbitrariedad de dispositivos y la migración de ubicación, sin necesidad de modificar la configuración de IP ni la puerta de enlace. Las diferentes redes L2 (VLAN) se enrutan a través de los conmutadores centrales. Sin embargo, en esta arquitectura, el conmutador central debe mantener una enorme tabla MAC y ARP, lo que impone altos requisitos de capacidad. Además, el conmutador de acceso (TOR) también limita la escalabilidad de toda la red. Esto, a su vez, limita la escalabilidad, la expansión y la elasticidad de la red. El problema del retraso en la programación de las tres capas impide satisfacer las necesidades futuras del negocio.

Por otro lado, el tráfico este-oeste generado por la tecnología de virtualización también plantea desafíos a la red tradicional de tres capas. El tráfico del centro de datos se puede dividir en las siguientes categorías:

Tráfico norte-sur:Tráfico entre clientes fuera del centro de datos y el servidor del centro de datos, o tráfico desde el servidor del centro de datos a Internet.

Tráfico este-oeste:Tráfico entre servidores dentro de un centro de datos, así como tráfico entre diferentes centros de datos, como recuperación ante desastres entre centros de datos, comunicación entre nubes privadas y públicas.

La introducción de la tecnología de virtualización hace que el despliegue de aplicaciones sea cada vez más distribuido y el "efecto secundario" es que el tráfico de este a oeste está aumentando.

Las arquitecturas tradicionales de tres niveles suelen estar diseñadas para el tráfico Norte-Sur.Si bien puede utilizarse para el tráfico de este a oeste, es posible que en última instancia no funcione como se espera.

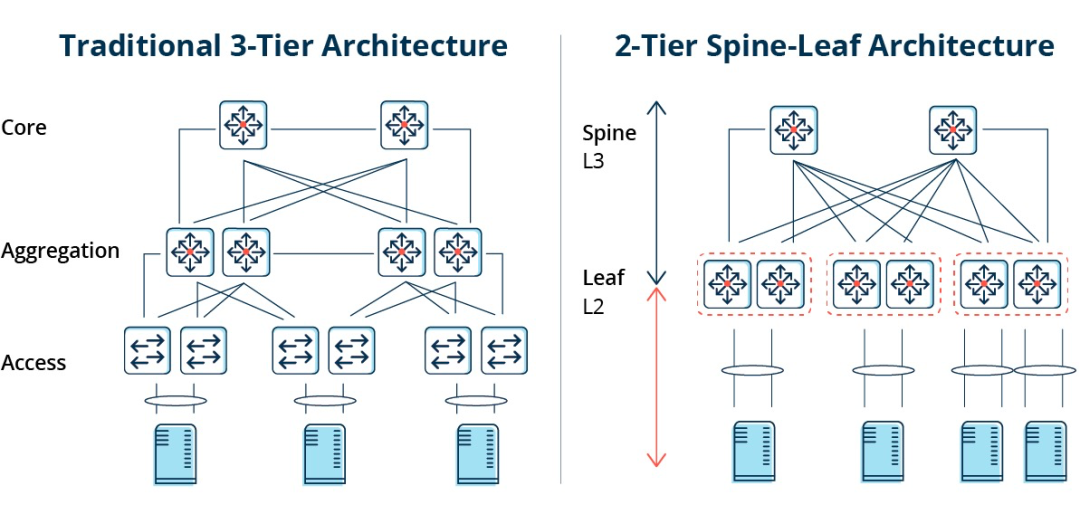

Arquitectura tradicional de tres niveles vs. arquitectura Spine-Leaf

En una arquitectura de tres niveles, el tráfico este-oeste debe reenviarse a través de dispositivos en las capas de agregación y núcleo, lo que implica pasar innecesariamente por muchos nodos. (Servidor -> Acceso -> Agregación -> Conmutador de núcleo -> Agregación -> Conmutador de acceso -> Servidor)

Por lo tanto, si una gran cantidad de tráfico de este a oeste pasa por una arquitectura de red tradicional de tres niveles, los dispositivos conectados al mismo puerto de conmutación pueden competir por el ancho de banda, lo que da como resultado tiempos de respuesta deficientes para los usuarios finales.

Desventajas de la arquitectura de red tradicional de tres capas

Se puede observar que la arquitectura de red tradicional de tres capas tiene muchas deficiencias:

Desperdicio de ancho de banda:Para evitar bucles, el protocolo STP generalmente se ejecuta entre la capa de agregación y la capa de acceso, de modo que solo un enlace ascendente del conmutador de acceso realmente transporta tráfico y los demás enlaces ascendentes se bloquearán, lo que resultará en un desperdicio de ancho de banda.

Dificultad en la colocación de redes a gran escala:Con la expansión de la escala de la red, los centros de datos se distribuyen en diferentes ubicaciones geográficas, las máquinas virtuales deben crearse y migrarse a cualquier lugar, y sus atributos de red, como direcciones IP y puertas de enlace, permanecen sin cambios, lo que requiere el soporte de la capa 2. En la estructura tradicional, no se puede realizar ninguna migración.

Falta de tráfico Este-Oeste:La arquitectura de red de tres niveles está diseñada principalmente para el tráfico Norte-Sur, aunque también admite el tráfico Este-Oeste. Sin embargo, sus deficiencias son evidentes. Cuando el tráfico Este-Oeste es elevado, la presión sobre los conmutadores de la capa de agregación y la capa central aumenta considerablemente, y el tamaño y el rendimiento de la red se limitan a estas últimas.

Esto hace que las empresas caigan en el dilema del costo y la escalabilidad:El soporte de redes de alto rendimiento a gran escala requiere una gran cantidad de equipos de capa de convergencia y de capa central, lo que no solo implica altos costos para las empresas, sino que también exige una planificación anticipada de la red durante su construcción. Cuando la escala de la red es pequeña, se desperdician recursos, y cuando la escala de la red continúa expandiéndose, se dificulta su expansión.

La arquitectura de red Spine-Leaf

¿Qué es la arquitectura de red Spine-Leaf?

En respuesta a los problemas mencionados,Ha surgido un nuevo diseño de centro de datos, la arquitectura de red Spine-Leaf, que es lo que llamamos red Leaf Ridge.

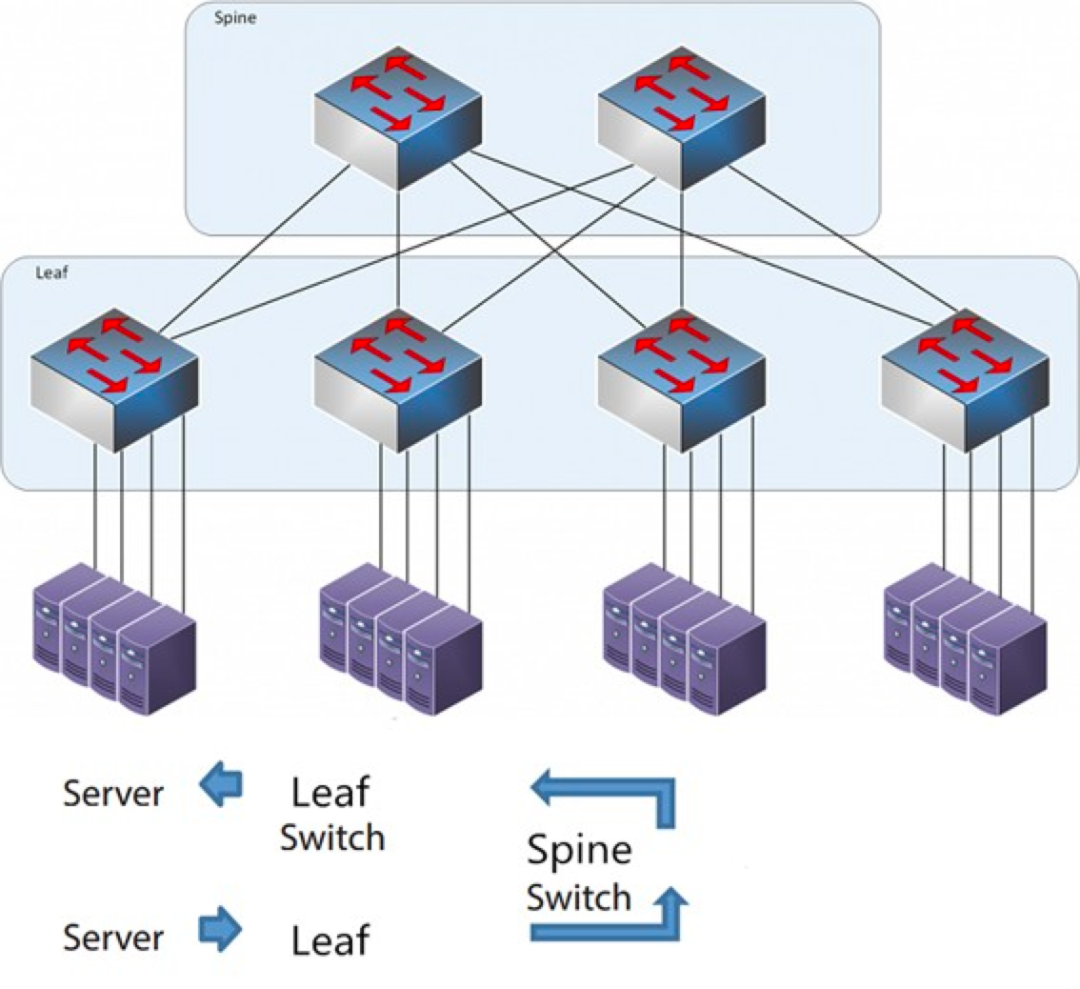

Como sugiere el nombre, la arquitectura tiene una capa Spine y una capa Leaf, incluidos conmutadores spine e interruptores leaf.

La arquitectura de la columna vertebral

Cada conmutador de hoja está conectado a todos los conmutadores de cresta, que no están conectados directamente entre sí, formando una topología de malla completa.

En el modelo spine-leaf, una conexión de un servidor a otro pasa por el mismo número de dispositivos (Servidor -> Leaf -> Switch Spine -> Switch Leaf -> Servidor), lo que garantiza una latencia predecible. Esto se debe a que un paquete solo necesita pasar por un spine y otra leaf para llegar a su destino.

¿Cómo funciona Spine-Leaf?

Conmutador Leaf: Equivale al conmutador de acceso en la arquitectura tradicional de tres capas y se conecta directamente al servidor físico como TOR (Top Of Rack). La diferencia con el conmutador de acceso radica en que el punto de demarcación de la red L2/L3 ahora se encuentra en el conmutador Leaf. El conmutador Leaf se encuentra por encima de la red de tres capas, y el conmutador Leaf se encuentra por debajo del dominio de difusión L2 independiente, lo que soluciona el problema de BUM de las grandes redes de dos capas. Si dos servidores Leaf necesitan comunicarse, deben utilizar el enrutamiento L3 y reenviarlo a través de un conmutador Spine.

Switch Spine: Equivalente a un switch de núcleo. Se utiliza ECMP (Equal Cost Multi Path) para seleccionar dinámicamente múltiples rutas entre los switches Spine y Leaf. La diferencia radica en que el Spine ahora simplemente proporciona una red de enrutamiento L3 resiliente para el switch Leaf, de modo que el tráfico norte-sur del centro de datos puede enrutarse desde el switch Spine en lugar de hacerlo directamente. El tráfico norte-sur puede enrutarse desde el switch Edge en paralelo al switch Leaf hasta el router WAN.

Comparación entre la arquitectura de red Spine/Leaf y la arquitectura de red tradicional de tres capas

Ventajas de Spine-Leaf

Departamento:Un diseño plano acorta la ruta de comunicación entre servidores, lo que resulta en una menor latencia, lo que puede mejorar significativamente el rendimiento de las aplicaciones y los servicios.

Buena escalabilidad:Cuando el ancho de banda es insuficiente, aumentar el número de conmutadores de cresta puede ampliarlo horizontalmente. Cuando aumenta el número de servidores, podemos añadir conmutadores de hoja si la densidad de puertos es insuficiente.

Reducción de costos: Tráfico en dirección norte y sur, ya sea saliendo de nodos hoja o de nodos cresta. Flujo este-oeste distribuido en múltiples rutas. De esta manera, la red de cresta hoja puede usar conmutadores de configuración fija sin necesidad de conmutadores modulares costosos, lo que reduce el costo.

Baja latencia y prevención de congestión:Los flujos de datos en una red Leaf Ridge tienen el mismo número de saltos, independientemente del origen y el destino, y dos servidores cualesquiera tienen tres saltos de Leaf a Spine y Leaf a Leaf. Esto establece una ruta de tráfico más directa, lo que mejora el rendimiento y reduce los cuellos de botella.

Alta seguridad y disponibilidad:El protocolo STP se utiliza en la arquitectura de red tradicional de tres niveles. Cuando un dispositivo falla, vuelve a converger, lo que afecta el rendimiento de la red o incluso provoca un fallo. En la arquitectura leaf-ridge, cuando un dispositivo falla, no es necesario volver a converger y el tráfico continúa circulando por otras rutas normales. La conectividad de la red no se ve afectada y el ancho de banda solo se reduce en una ruta, con un impacto mínimo en el rendimiento.

El balanceo de carga mediante ECMP es ideal para entornos donde se utilizan plataformas de gestión de red centralizadas como SDN. SDN simplifica la configuración, la gestión y el redireccionamiento del tráfico en caso de bloqueo o fallo del enlace, lo que convierte la topología de malla completa de balanceo de carga inteligente en una forma relativamente sencilla de configurar y gestionar.

Sin embargo, la arquitectura Spine-Leaf tiene algunas limitaciones:

Una desventaja es que la cantidad de switches aumenta el tamaño de la red. El centro de datos con arquitectura de red leaf-ridge necesita aumentar la cantidad de switches y equipos de red proporcionalmente al número de clientes. A medida que aumenta el número de hosts, se necesita una gran cantidad de switches leaf para el enlace ascendente al switch de cresta.

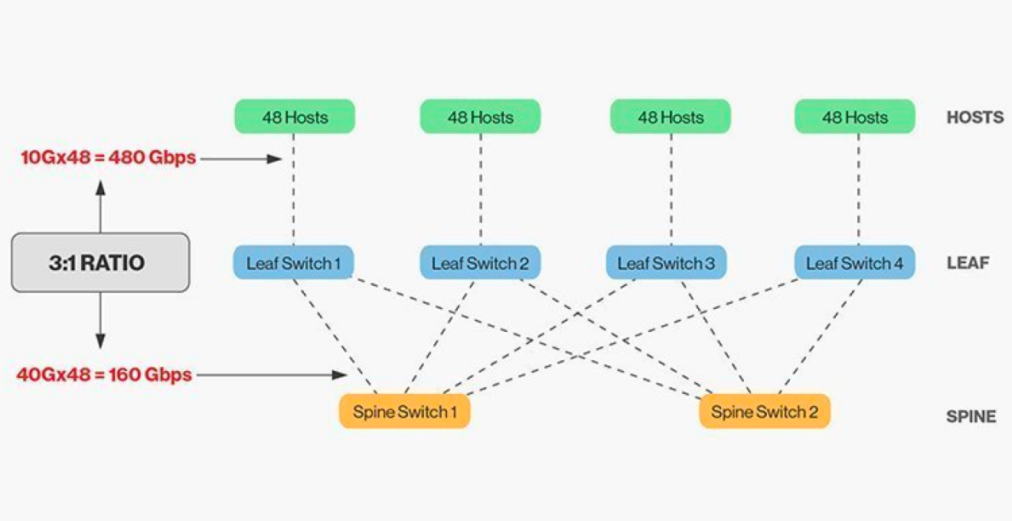

La interconexión directa de los conmutadores de cresta y de hoja requiere coincidencia y, en general, la relación de ancho de banda razonable entre los conmutadores de cresta y de hoja no puede superar 3:1.

Por ejemplo, hay 48 clientes con una velocidad de 10 Gbps en el switch leaf con una capacidad total de puertos de 480 Gb/s. Si los cuatro puertos de enlace ascendente de 40 Gb/s de cada switch leaf se conectan al switch de cresta de 40 Gb/s, este tendrá una capacidad de enlace ascendente de 160 Gb/s. La relación es de 480:160 (3:1). Los enlaces ascendentes del centro de datos suelen ser de 40 Gb/s o 100 Gb/s y pueden migrarse con el tiempo desde un punto de partida de 40 Gb/s (Nx 40 Gb/s) a 100 Gb/s (Nx 100 Gb/s). Es importante tener en cuenta que el enlace ascendente siempre debe ser más rápido que el enlace descendente para no bloquear el enlace del puerto.

Las redes Spine-Leaf también tienen requisitos de cableado claros. Dado que cada nodo leaf debe estar conectado a cada switch de la red, es necesario tender más cables de cobre o fibra óptica. La distancia de interconexión incrementa el coste. Dependiendo de la distancia entre los switches interconectados, la cantidad de módulos ópticos de alta gama que requiere la arquitectura Spine-Leaf es diez veces mayor que la de la arquitectura tradicional de tres niveles, lo que incrementa el coste total de implementación. Sin embargo, esto ha impulsado el crecimiento del mercado de módulos ópticos, especialmente para módulos ópticos de alta velocidad como 100G y 400G.

Hora de publicación: 26 de enero de 2026